Einleitung: Warum der EU AI Act für Produktberater anders ist

Der EU AI Act markiert einen Wendepunkt in der Regulierung künstlicher Intelligenz in Europa. Am 1. August 2024 in Kraft getreten, zielt dieses wegweisende Gesetz darauf ab, die Entwicklung und den Einsatz von KI-Technologien verantwortungsvoll zu gestalten. Für Unternehmen, die KI Chatbots einsetzen, ist das Verständnis dieser Verordnung von entscheidender Bedeutung – besonders wenn diese Chatbots aktiv Produkte empfehlen und Kaufentscheidungen beeinflussen.

Die meisten Artikel zum EU AI Act fokussieren sich auf einfache Support-Bots, die Öffnungszeiten nennen oder FAQ beantworten. Doch für E-Commerce-Unternehmen, die KI-Produktberater einsetzen, sieht die Realität anders aus. Wenn dein Chatbot sagt Dieses Fahrrad ist für Personen bis 2 Meter Körpergröße geeignet und diese Aussage falsch ist, betrittst du ein völlig anderes Haftungsgebiet als ein Bot, der nur Wir haben bis 18 Uhr geöffnet antwortet.

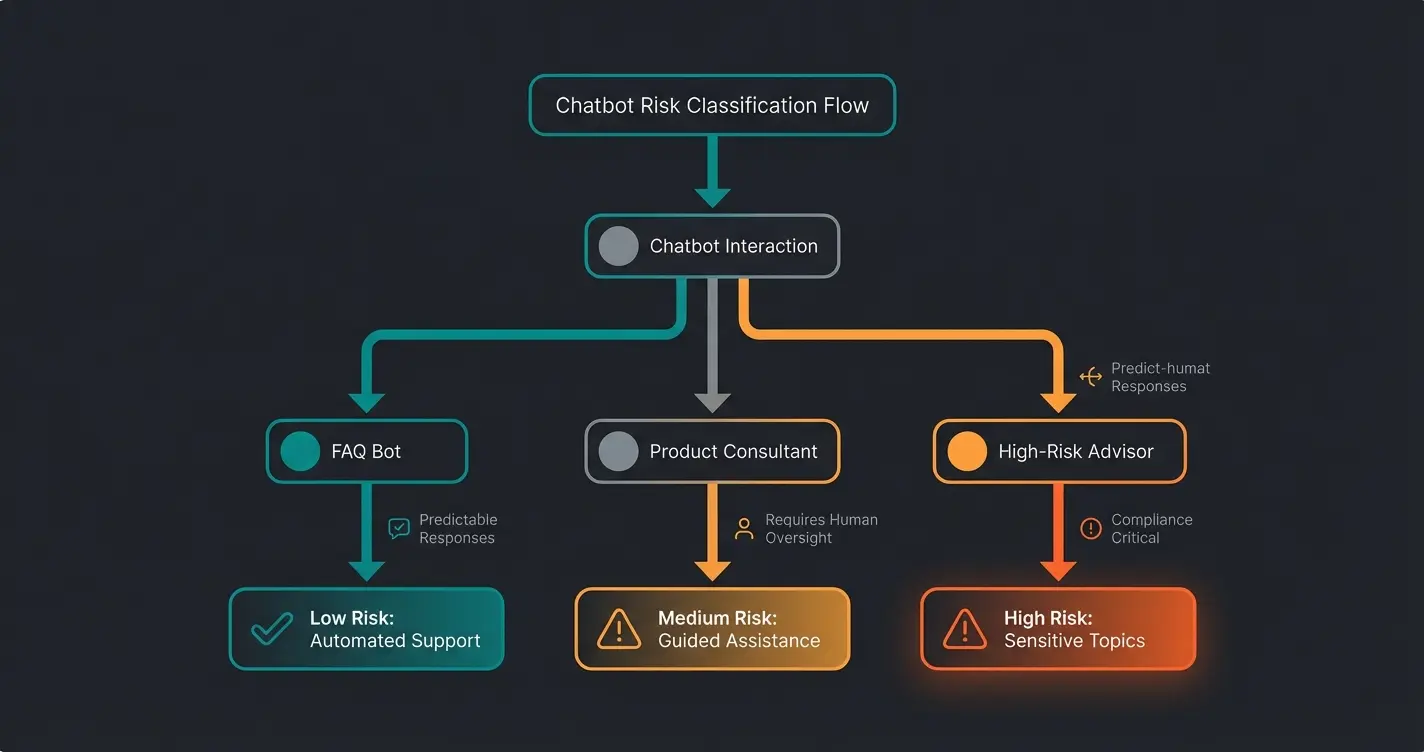

Der EU AI Act verfolgt einen risikobasierten Ansatz und kategorisiert KI-Systeme in vier Risikoklassen: unakzeptables Risiko (verboten), hohes Risiko (streng reguliert), begrenztes Risiko (Transparenzanforderungen) und minimales Risiko (unreguliert). Diese Einstufung hat weitreichende Auswirkungen des EU AI Acts auf die Entwicklung, den Einsatz und die Überwachung von KI-Systemen, einschließlich deiner Produktberatungs-Chatbots.

Für Unternehmen, die KI Chatbots in ihren Geschäftsprozessen integriert haben oder dies planen, ist es unerlässlich, die spezifischen Anforderungen zu verstehen. Die Verordnung betrifft nicht nur Anbieter von KI-Systemen, sondern auch Nutzer, Importeure und Vertreiber innerhalb der EU oder solche, die Menschen in der EU beeinflussen. Mit potenziellen Strafen von bis zu 35 Millionen Euro oder 7% des globalen Jahresumsatzes unterstreicht der EU AI Act die Dringlichkeit der Chatbot Compliance.

Was sind KI Chatbots laut EU AI Act?

Im Rahmen des EU AI Act werden KI Chatbots als fortschrittliche Dialogsysteme betrachtet, die auf künstlicher Intelligenz basieren. Sie fallen unter die breite Definition von KI-Systemen, die im Gesetz als Software verstanden werden, die mit Techniken des maschinellen Lernens, logik- und wissensbasierten Ansätzen oder statistischen Methoden entwickelt wurde und in der Lage ist, für bestimmte von Menschen festgelegte Ziele Inhalte, Vorhersagen, Empfehlungen oder Entscheidungen zu generieren.

KI Chatbots zeichnen sich durch folgende Merkmale aus:

- Natürliche Sprachverarbeitung: Fähigkeit, menschliche Sprache zu verstehen und zu generieren

- Kontextverständnis: Analyse und Interpretation des Gesprächskontexts für relevante Antworten

- Lernfähigkeit: Kontinuierliche Verbesserung durch Interaktionen und Feedback

- Personalisierung: Anpassung der Antworten an individuelle Nutzerbedürfnisse und Präferenzen

- Autonomie: Fähigkeit, selbstständig Entscheidungen zu treffen und Antworten zu generieren

Im Gegensatz zu herkömmlichen regelbasierten Chatbots, die auf vordefinierten Skripten basieren, nutzen KI Chatbots komplexe Algorithmen und Datenanalyse, um dynamisch auf Nutzereingaben zu reagieren. Diese Fähigkeit zur adaptiven Interaktion und Entscheidungsfindung macht sie zu einem leistungsfähigen Werkzeug für den Kundenservice per KI, birgt aber auch potenzielle Risiken, die der EU AI Act adressiert.

Die Einordnung eines Chatbots als KI-System nach dem EU AI Act hängt von seiner spezifischen Funktionsweise und seinem Einsatzbereich ab. Entscheidend ist, ob der Chatbot eigenständig Inhalte generiert, Entscheidungen trifft oder Empfehlungen gibt, die über einfache vordefinierte Antworten hinausgehen. Je autonomer und komplexer die Entscheidungsprozesse des Chatbots sind, desto wahrscheinlicher ist seine Klassifizierung als KI-System im Sinne des Gesetzes.

Die Chatbot Risikoklassen im EU AI Act verstehen

Der EU AI Act nimmt eine risikoorientierte Herangehensweise zur Regulierung von künstlicher Intelligenz vor. Für KI Chatbots ist es wichtig zu verstehen, wie sie in diesem Rahmenwerk eingeordnet werden – und hier unterscheiden sich Produktberater fundamental von einfachen FAQ-Bots.

Verbotene KI-Anwendungen wie Social Scoring oder manipulative Systeme – für E-Commerce nicht relevant

Strenge Auflagen für KI in sensiblen Bereichen wie Medizinprodukte, Finanzberatung oder Kreditwürdigkeitsprüfung

Transparenzpflichten für die meisten E-Commerce-Chatbots – Nutzer müssen wissen, dass sie mit KI sprechen

Weitgehend unregulierte Anwendungen wie Spam-Filter oder einfache Automatisierungen

Allgemeine Klassifizierung für E-Commerce

Der EU AI Act teilt KI-Systeme in vier Risikokategorien ein:

- Unakzeptables Risiko: KI-Anwendungen, die verboten sind (z.B. Social Scoring, manipulative Systeme)

- Hohes Risiko: KI-Systeme mit strengen regulatorischen Auflagen (z.B. medizinische Diagnose, Kreditwürdigkeitsprüfung)

- Begrenztes Risiko: KI mit Transparenzanforderungen – hier fallen die meisten E-Commerce-Chatbots hinein

- Minimales Risiko: Weitgehend unregulierte KI-Anwendungen (z.B. Spam-Filter)

Die meisten KI Chatbots fallen in die Kategorien mit begrenztem oder minimalem Risiko. Allerdings hängt die genaue Einstufung vom spezifischen Einsatzbereich und den Funktionen des Chatbots ab. Hier liegt der entscheidende Unterschied: Ein Bot, der nur Öffnungszeiten nennt, ist klar Limited Risk. Ein Produktberater, der aktiv Kaufempfehlungen ausspricht, bewegt sich in einer Grauzone.

Risikokategorien speziell für Produktberater

Für KI Chatbots im E-Commerce sind besonders die Kategorien mit begrenztem und hohem Risiko relevant:

Begrenztes Risiko: Hierunter fallen viele Standard-Chatbots für Kundenservice oder Produktberatung. Sie müssen Transparenzanforderungen erfüllen, etwa den Nutzer darüber informieren, dass er mit einem KI-System interagiert. Das ist die Kategorie, in die die meisten deiner Produktberater fallen werden.

Hohes Risiko: Chatbots könnten als hochriskant eingestuft werden, wenn sie in sensiblen Bereichen wie Gesundheitsberatung, Finanzdienstleistungen oder bei Medizinprodukten eingesetzt werden. Hier gelten strenge Auflagen bezüglich Datenschutz, Sicherheit und menschlicher Aufsicht. Wenn dein Shop etwa Nahrungsergänzungsmittel verkauft und der Chatbot Dosierungsempfehlungen gibt, bewegst du dich möglicherweise bereits in diesem Bereich.

Die genaue Einordnung eines KI Chatbots erfordert eine sorgfältige Prüfung seiner Funktionen und seines Einsatzbereichs. Unternehmen sollten sich mit den Kriterien des EU AI Acts vertraut machen, um ihre Chatbots rechtskonform zu gestalten und gleichzeitig die Vorteile der Produktberatung per KI voll auszuschöpfen.

Leitfaden zur Einordnung deines KI Chatbots

Um einen KI Chatbot gemäß den Standards des EU AI Acts einzuordnen, solltest du einen strukturierten Ansatz verfolgen. Hier ist ein Leitfaden in drei Schritten, der speziell auf Produktberater im E-Commerce zugeschnitten ist:

Schritt 1: Bewertung des Einsatzbereichs

Der erste Schritt ist die genaue Analyse des Einsatzbereichs deines Chatbots:

- Branche: In welchem Sektor wird der Chatbot eingesetzt? Besonders sensibel sind Bereiche wie Gesundheit, Finanzen oder öffentliche Dienste.

- Zielgruppe: Wer sind die Nutzer? Besondere Vorsicht ist geboten bei vulnerablen Gruppen wie Kindern oder älteren Menschen.

- Entscheidungsrelevanz: Welche Auswirkungen haben die Interaktionen mit dem Chatbot? Je größer die potenziellen Konsequenzen einer falschen Empfehlung, desto höher das Risiko.

- Verkaufseinfluss: Führt der Chatbot aktiv zum Kauf oder beantwortet er nur Fragen? Aktive Kaufempfehlungen erhöhen die Haftung.

Schritt 2: Analyse der Funktionalitäten

Im nächsten Schritt werden die spezifischen Fähigkeiten deines Chatbots untersucht:

- Komplexität: Wie fortgeschritten sind die KI-Funktionen? Einfache regelbasierte Systeme haben ein geringeres Risiko als hochentwickelte Machine Learning Modelle.

- Autonomie: In welchem Maße trifft der Chatbot eigenständige Entscheidungen ohne menschliche Kontrolle?

- Lernfähigkeit: Passt sich der Chatbot durch Interaktionen an? Kontinuierliches Lernen erhöht potenziell das Risiko für unerwartete Outputs.

- Produktaussagen: Macht der Chatbot konkrete Aussagen über Produkteigenschaften, Eignung oder Sicherheit?

Schritt 3: Datenschutz und Sicherheitsaspekte

Schließlich müssen Datenschutz und Sicherheit berücksichtigt werden:

- Datenverarbeitung: Welche Art von Daten verarbeitet der Chatbot? Besonders kritisch sind personenbezogene oder sensible Daten.

- Datenspeicherung: Wie und wo werden die Daten gespeichert? EU-Datenschutzstandards müssen eingehalten werden.

- Sicherheitsmaßnahmen: Welche Vorkehrungen gibt es gegen Missbrauch oder unbefugten Zugriff?

- DSGVO-Konformität: Sind alle Anforderungen der Datenschutz-Grundverordnung erfüllt?

Die Einhaltung der EU-Datenschutzstandards ist entscheidend für die Risikobewertung und Compliance mit dem EU AI Act. Beachte: AI-Act-Compliance ersetzt nicht die DSGVO-Konformität – beide Regelwerke müssen parallel erfüllt werden.

Die Art. 50 Transparenzpflicht: Mehr als nur ein Disclaimer

Die zentrale Anforderung für die meisten E-Commerce-Chatbots ist die Transparenzpflicht nach Artikel 50 des EU AI Acts. Nutzer müssen wissen, dass sie mit einem KI-System interagieren. Doch die Art der Umsetzung macht den Unterschied zwischen einem Vertrauens-Killer und einem Conversion-Booster.

Schlechte vs. gute Disclaimer-Beispiele

Die Formulierung deines Disclaimers entscheidet darüber, ob Nutzer das Vertrauen gewinnen oder verlieren:

| Schlechte Praxis | Gute Praxis | Warum es wichtig ist |

|---|---|---|

| Hans vom Support mit Stock-Foto einer Person | Produkt-Assistent (KI-gestützt) | Ehrlichkeit baut langfristiges Vertrauen auf |

| Kein Hinweis auf KI-Nutzung | Ich bin ein virtueller Berater und helfe dir bei der Produktauswahl | Erfüllt Art. 50 und setzt klare Erwartungen |

| Disclaimer versteckt in den AGB | Sichtbarer Hinweis direkt im Chat-Interface | Nutzer müssen aktiv informiert werden |

| Bot ohne weitere Erklärung | KI-Assistent – Produktdetails bitte in der Beschreibung prüfen | Reduziert Haftungsrisiko bei Falschaussagen |

Muster-Formulierungen für deinen Produktberater

Hier sind bewährte Disclaimer-Texte, die du direkt verwenden kannst:

Der Schlüssel liegt darin, den Disclaimer nicht als lästige Pflicht zu sehen, sondern als Chance: Transparenz baut das Vertrauen auf, das für eine Kaufentscheidung notwendig ist. Nutzer, die wissen, dass sie mit einer KI sprechen, haben realistischere Erwartungen – und sind am Ende zufriedener mit der Interaktion.

Die Haftungsfalle: Produktberatung vs. FAQ-Bots

Hier liegt der entscheidende Unterschied, den die meisten Artikel zum EU AI Act übersehen: Ein FAQ-Bot, der sagt Wir haben bis 18 Uhr geöffnet, trägt ein völlig anderes Haftungsrisiko als ein Produktberater, der behauptet Dieses E-Bike hat eine Reichweite von 120 km.

Was passiert bei falscher Produktberatung?

Wenn dein KI-Produktberater falsche Aussagen über ein Produkt macht, betrittst du das Gebiet der Sachmangelhaftung und Falschberatung. Nach deutschem Recht kann dies erhebliche Konsequenzen haben:

- Sachmangelhaftung (§ 434 BGB): Wenn der Chatbot Eigenschaften zusagt, die das Produkt nicht hat, liegt ein Sachmangel vor

- Falschberatung: Fehlerhafte Empfehlungen können zu Schadensersatzansprüchen führen

- Störerhaftung: Als Betreiber haftest du für die Aussagen deines KI-Systems

- Wettbewerbsrecht (UWG): Irreführende Produktaussagen können als unlauterer Wettbewerb gelten

Typische Risikoszenarien im E-Commerce

Diese Situationen sind besonders haftungsrelevant:

| Szenario | Risiko | Lösung |

|---|---|---|

| Chatbot nennt falsche Produktmaße | Rücksendungen, Schadensersatz | RAG-System mit verifizierten Produktdaten |

| KI erfindet Produktfeatures (Halluzination) | Falschberatung, UWG-Verstoß | Grounding auf offizielle Produktdatenbank |

| Ungeeignete Produktempfehlung für Anwendungsfall | Haftung bei Schäden | Disclaimer + Eskalation an Menschen |

| Falsche Kompatibilitätsaussagen | Rücksendungen, Vertrauensverlust | Strukturierte Kompatibilitätsdaten |

Technische Guardrails: So verhinderst du Halluzinationen

Die gute Nachricht: Mit den richtigen technischen Maßnahmen kannst du das Risiko falscher Produktaussagen drastisch reduzieren. Der Schlüssel liegt in sogenannten Guardrails – technischen Sicherheitsmechanismen, die verhindern, dass dein Chatbot Informationen erfindet.

RAG: Retrieval Augmented Generation erklärt

RAG (Retrieval Augmented Generation) ist die wichtigste Technologie, um Halluzinationen bei Produktberatern zu verhindern. Statt frei zu halluzinieren, greift der Chatbot bei jeder Antwort auf deine verifizierte Produktdatenbank zu:

Der Kunde fragt: Ist dieses Sofa für kleine Wohnungen geeignet?

Das System durchsucht deine Produktdatenbank nach den offiziellen Maßen und Eigenschaften

Die gefundenen Fakten werden dem KI-Modell als Kontext übergeben

Die KI formuliert eine Antwort basierend auf den verifizierten Daten – keine Erfindungen

Praktische Implementierung

Um dein KI-System rechtssicher zu gestalten, solltest du folgende Maßnahmen implementieren:

- Verifizierte Datenquellen: Der Chatbot darf nur auf geprüfte Produktinformationen zugreifen

- Confidence Scores: Bei Unsicherheit sollte der Bot an einen Menschen eskalieren

- Quellenangaben: Der Chatbot sollte bei Produktaussagen auf die Produktseite verweisen können

- Regelmäßige Audits: Überprüfe regelmäßig die Antworten deines Chatbots auf Korrektheit

- Feedback-Loops: Implementiere Mechanismen, um falsche Aussagen zu identifizieren und zu korrigieren

KI Chatbots mit geringem Risiko: Die Standard-Kategorie

Im Rahmen des EU AI Act werden KI Chatbots, die als Systeme mit geringem Risiko eingestuft werden, weniger strengen regulatorischen Anforderungen unterliegen. Diese Kategorie umfasst die meisten alltäglichen Anwendungen von KI Chatbots, die in der Regel keine signifikante Gefahr für die Rechte oder die Sicherheit von Nutzern darstellen.

Merkmale und Beispiele

KI Chatbots mit geringem Risiko zeichnen sich durch folgende Merkmale aus:

- Begrenzte Funktionalität: Sie führen einfache Aufgaben aus, wie die Beantwortung häufig gestellter Fragen oder die Bereitstellung allgemeiner Informationen.

- Keine sensiblen Daten: Sie verarbeiten keine hochsensiblen persönlichen Informationen wie Gesundheitsdaten oder Finanzinformationen.

- Transparente Interaktion: Nutzer sind sich bewusst, dass sie mit einem KI-System interagieren – der Disclaimer ist klar sichtbar.

- Keine autonomen Entscheidungen: Sie treffen keine wichtigen Entscheidungen ohne menschliche Überprüfung oder Eskalationsmöglichkeit.

Typische Beispiele für KI Chatbots mit geringem Risiko im E-Commerce sind:

- Kundenservice-Bots: KI-gestützte Systeme, die grundlegende Anfragen wie Lieferstatus, Öffnungszeiten oder Rückgabebedingungen bearbeiten.

- Produktberatungs-Assistenten: Chatbots, die bei der Produktauswahl unterstützen, solange sie auf verifizierte Daten zugreifen und keine medizinischen oder finanziellen Empfehlungen geben.

- Informations-Bots: KI-Systeme, die allgemeine Auskünfte zu Unternehmen oder Dienstleistungen geben und bei komplexen Fragen an Menschen verweisen.

Regulatorische Anforderungen für Limited Risk

Obwohl KI Chatbots mit geringem Risiko weniger streng reguliert werden, müssen sie dennoch bestimmte Anforderungen erfüllen:

- Transparenz (Art. 50): Nutzer müssen aktiv darüber informiert werden, dass sie mit einem KI-System interagieren – und zwar bevor die Interaktion beginnt.

- Datenschutz (DSGVO): Einhaltung aller relevanten Datenschutzbestimmungen parallel zum AI Act.

- Keine Diskriminierung: Der Chatbot darf keine diskriminierenden Inhalte produzieren oder bestimmte Nutzergruppen benachteiligen.

- Überwachung: Regelmäßige Überprüfung der Leistung und Auswirkungen des Systems durch den Betreiber.

Diese Anforderungen zielen darauf ab, ein Mindestmaß an Sicherheit und Vertrauen für die Nutzer zu gewährleisten, ohne die Innovation und den Einsatz nützlicher KI-Technologien übermäßig einzuschränken. Unternehmen, die KI Chatbots mit geringem Risiko einsetzen, sollten diese Richtlinien als Chance sehen, das Vertrauen ihrer Kunden zu stärken und gleichzeitig von den Vorteilen der KI-Technologie zu profitieren.

Unsere KI-Produktberater sind von Grund auf für EU AI Act Compliance entwickelt: mit RAG-Technologie, transparenten Disclaimern und intelligentem Eskalationspfad.

Jetzt Demo vereinbarenKI Chatbots mit hohem Risiko: Wann wird es kritisch?

Der EU AI Act definiert bestimmte KI-Anwendungen als Hochrisiko-Systeme, die strengeren regulatorischen Auflagen unterliegen. KI Chatbots können unter bestimmten Umständen in diese Kategorie fallen, was für Entwickler und Anwender weitreichende Konsequenzen hat.

Kriterien für Hochrisiko-Einstufung

Ein KI Chatbot wird als Hochrisiko-System eingestuft, wenn er folgende Kriterien erfüllt:

- Entscheidungsgewalt: Der Chatbot trifft autonome Entscheidungen mit erheblichen Auswirkungen auf Individuen oder Gruppen – z.B. Kreditwürdigkeit oder medizinische Einschätzungen.

- Sensible Bereiche: Einsatz in kritischen Sektoren wie Gesundheitswesen, Finanzen, Bildung oder bei Medizinprodukten.

- Persönliche Daten: Verarbeitung großer Mengen sensibler persönlicher Informationen wie Gesundheitsdaten.

- Sicherheitsrelevanz: Potenzielle Gefährdung der Sicherheit oder Grundrechte von Nutzern durch fehlerhafte Empfehlungen.

Beispiele und Anwendungsfälle

Konkrete Beispiele für KI Chatbots, die als Hochrisiko-Systeme eingestuft werden könnten, sind:

- Medizinische Diagnose-Bots: Chatbots, die Krankheiten diagnostizieren oder Behandlungen empfehlen – auch Nahrungsergänzungsmittel-Dosierungen können hierunter fallen.

- Finanzberatungs-Bots: KI-Systeme, die autonome Investitionsentscheidungen treffen oder Kreditempfehlungen aussprechen.

- Behördliche Entscheidungs-Bots: Chatbots, die über Sozialleistungen, Visa oder ähnliche Anträge entscheiden.

- Psychologische Beratungs-Bots: KI-Systeme, die therapeutische Unterstützung ohne menschliche Überwachung bieten.

Strenge regulatorische Auflagen

Hochrisiko-KI-Chatbots müssen strenge Anforderungen erfüllen, die weit über die Transparenzpflicht hinausgehen:

- Risikoanalyse: Umfassende Bewertung und Dokumentation potenzieller Risiken vor dem Einsatz.

- Datenqualität: Verwendung hochwertiger, repräsentativer und fehlerfreier Trainingsdaten mit Dokumentation.

- Transparenz: Detaillierte Dokumentation der Funktionsweise und Entscheidungsprozesse für Behörden.

- Menschliche Aufsicht: Implementierung effektiver Überwachungsmechanismen durch qualifizierte menschliche Experten.

- Robustheit und Genauigkeit: Gewährleistung zuverlässiger und präziser Ergebnisse unter verschiedenen Bedingungen.

- Cybersicherheit: Implementierung starker Sicherheitsmaßnahmen zum Schutz vor Manipulation und Angriffen.

Besondere Aufmerksamkeit gilt der digitalen Barrierefreiheit und der Vermeidung von Diskriminierung. Hochrisiko-KI-Chatbots müssen so gestaltet sein, dass sie für alle Nutzergruppen zugänglich sind und keine Vorurteile oder unfaire Behandlung bestimmter Personengruppen aufweisen.

Die Einhaltung dieser strengen Auflagen erfordert erhebliche Ressourcen und Expertise. Unternehmen, die Hochrisiko-KI-Chatbots entwickeln oder einsetzen, müssen sorgfältig abwägen, ob der potenzielle Nutzen die regulatorischen Herausforderungen rechtfertigt. In vielen Fällen kann es ratsam sein, KI-Systeme so zu gestalten, dass sie in die Kategorie mit geringerem Risiko fallen.

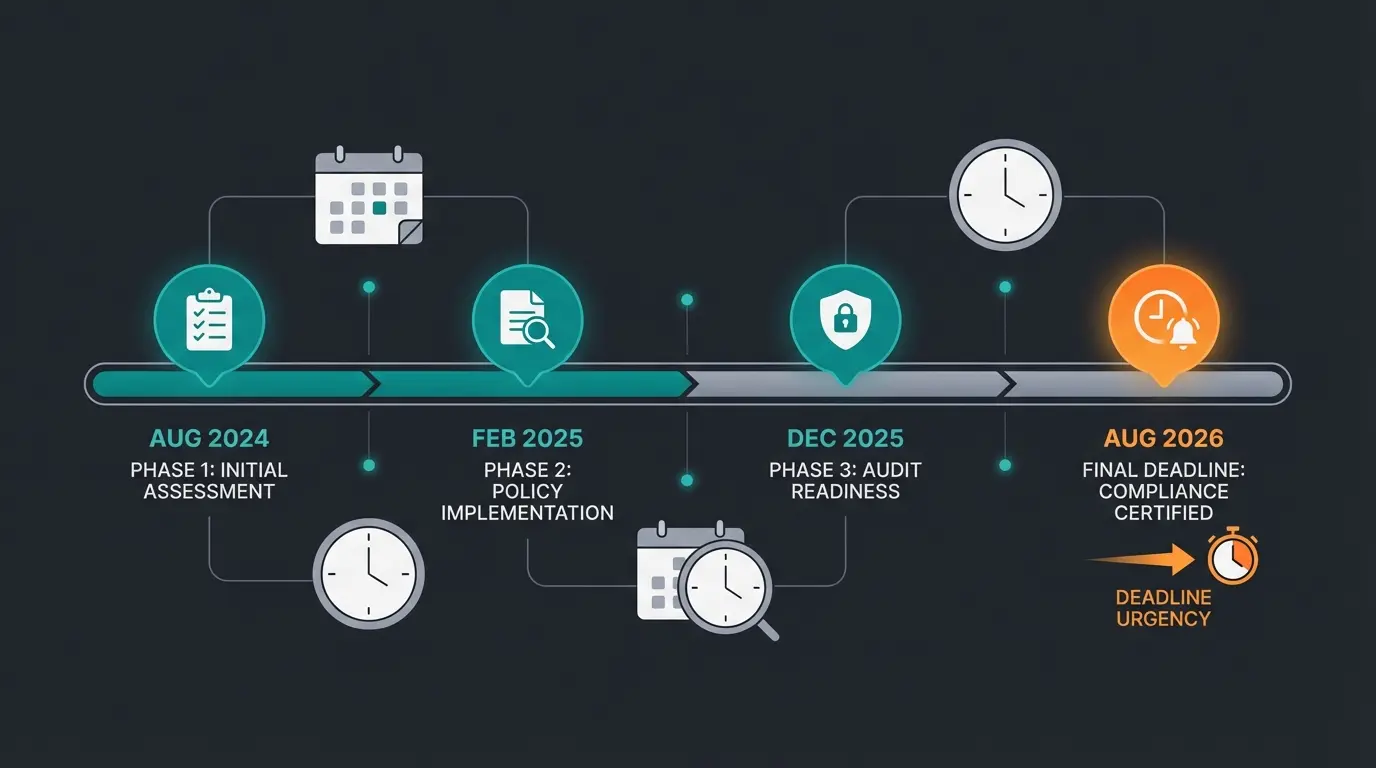

Timeline: Wann musst du compliant sein?

Der EU AI Act tritt schrittweise in Kraft. Diese Fristen sind für deine Planung entscheidend:

Der EU AI Act ist offiziell in Kraft getreten

Verbotene KI-Praktiken müssen eingestellt werden

Regeln für General Purpose AI wie ChatGPT

Alle Bestimmungen für Hochrisiko-Systeme gelten

Für die meisten E-Commerce-Chatbots mit Limited Risk sind die Transparenzpflichten bereits relevant. Die gute Nachricht: Wenn du jetzt mit der Implementierung beginnst, hast du ausreichend Zeit für eine saubere Umsetzung. Warte nicht bis zur letzten Minute – die Integration von Compliance-Maßnahmen in bestehende Systeme braucht Zeit.

Compliance-Checkliste für deinen Produktberater

Nutze diese Checkliste, um den Compliance-Status deines KI-Chatbots zu überprüfen:

| Anforderung | Status prüfen | Priorität |

|---|---|---|

| Transparenz-Statement sichtbar zu Beginn der Interaktion? | Art. 50 Pflicht | Hoch |

| Output basiert auf verifizierten Produktdaten (RAG)? | Haftungsschutz | Hoch |

| Eskalationspfad zu menschlichen Beratern vorhanden? | Best Practice | Mittel |

| Copyright-Checks bei Trainingsdaten durchgeführt? | Rechtssicherheit | Mittel |

| DSGVO-Konformität parallel zum AI Act gewährleistet? | Gesetzliche Pflicht | Hoch |

| Regelmäßige Audits der Chatbot-Antworten geplant? | Qualitätssicherung | Mittel |

| Disclaimer-Texte rechtlich geprüft? | Haftungsschutz | Hoch |

| Dokumentation der Funktionsweise vorhanden? | AI Act Anforderung | Mittel |

Praktische Tipps zur Compliance mit dem EU AI Act

Um die Compliance von KI Chatbots mit dem EU AI Act sicherzustellen, solltest du folgende praktische Maßnahmen ergreifen:

Dokumentation und Transparenz: Erstelle eine umfassende Dokumentation über die Funktionsweise, den Zweck und die Datengrundlage deines KI Chatbots. Stelle sicher, dass diese Informationen für Nutzer leicht zugänglich sind, um die Transparenzanforderungen des EU AI Act zu erfüllen. Dies ist nicht nur rechtlich erforderlich, sondern stärkt auch das Vertrauen deiner Kunden.

Risikobewertung durchführen: Führe eine gründliche Risikobewertung deines KI Chatbots durch. Berücksichtige dabei potenzielle Auswirkungen auf Grundrechte, Sicherheit und mögliche diskriminierende Effekte. Diese Bewertung hilft bei der korrekten Einordnung in die Risikokategorien des EU AI Act und identifiziert Handlungsbedarf.

Kontinuierliches Monitoring: Implementiere ein System zur kontinuierlichen Überwachung der Leistung und Auswirkungen deines KI Chatbots. Dies ermöglicht es dir, potenzielle Probleme frühzeitig zu erkennen und entsprechend zu reagieren – bevor ein Kunde sich beschwert oder rechtliche Schritte einleitet.

Menschliche Aufsicht: Stelle sicher, dass eine angemessene menschliche Aufsicht über den KI Chatbot gewährleistet ist, insbesondere wenn er als System mit hohem Risiko eingestuft wird. Dies kann die Einrichtung von Eskalationsmechanismen für komplexe oder sensible Anfragen umfassen – ein Hybrid-Workflow ist oft die beste Lösung.

Regelmäßige Überprüfungen: Führe regelmäßige Überprüfungen und Audits deines KI Chatbots durch, um sicherzustellen, dass er weiterhin den Anforderungen des EU AI Act entspricht. Berücksichtige dabei auch Änderungen in der Gesetzgebung oder neue Interpretationen der Verordnung durch Behörden und Gerichte.

Compliance als Wettbewerbsvorteil nutzen

Der EU AI Act wird oft als Bürde dargestellt. Doch für Unternehmen, die ihn richtig umsetzen, ist er ein echter Wettbewerbsvorteil. Warum? Weil Transparenz und Verlässlichkeit genau das sind, was Kunden bei einer Kaufentscheidung brauchen.

Ein KI-Produktberater, der offen kommuniziert, dass er eine KI ist, und der nur verifizierte Produktinformationen nennt, baut mehr Vertrauen auf als ein mysteriöser Hans vom Support mit gefälschtem Profilbild. Kunden schätzen Ehrlichkeit – und sie kaufen eher bei Unternehmen, denen sie vertrauen.

Die Implementierung von Guardrails wie RAG-Systemen verbessert nicht nur die Compliance, sondern auch die Qualität deiner Produktberatung. Weniger Halluzinationen bedeuten weniger Rücksendungen, weniger Beschwerden und zufriedenere Kunden. Das ist kein Kostenfaktor – das ist eine Investition mit messbarem ROI.

FAQ: Häufige Fragen zum EU AI Act und Chatbots

Ja, der EU AI Act gilt für alle Unternehmen, die KI-Systeme in der EU einsetzen oder EU-Bürger damit erreichen – unabhängig von der Unternehmensgröße. Die gute Nachricht: Die meisten kleinen Shops nutzen Chatbots mit Limited Risk, für die primär die Transparenzpflicht gilt. Ein einfacher, sichtbarer Hinweis, dass der Nutzer mit einer KI spricht, erfüllt die Grundanforderung.

Nein, die Nutzung eines compliant entwickelten Basis-Modells macht deinen Chatbot nicht automatisch rechtskonform. Du als Deployer (Anwender) bist verantwortlich für die Art, wie du das System einsetzt. Dazu gehören: der sichtbare Transparenz-Disclaimer, die Qualität der Produktdaten, die du einspeist, und die Überwachung der Ausgaben. Die Verantwortung für Falschaussagen liegt bei dir, nicht bei OpenAI.

Bei falschen Produktaussagen greift das deutsche Gewährleistungsrecht. Wenn der Chatbot Eigenschaften zusagt, die das Produkt nicht hat, kann dies als Sachmangel gewertet werden. Der Kunde hat dann Anspruch auf Nacherfüllung, Minderung oder Rücktritt. Zusätzlich können Schadensersatzansprüche entstehen. Deshalb ist die Implementierung von RAG-Systemen so wichtig – sie greifen nur auf verifizierte Produktdaten zu.

Die Kennzeichnung muss klar, sichtbar und vor Beginn der Interaktion erfolgen. Bewährte Formulierungen sind: Ich bin ein KI-gestützter Produkt-Assistent oder Virtueller Berater (KI-gestützt). Vermeide menschliche Namen mit Profilbildern, die eine echte Person suggerieren. Der Hinweis sollte im Chat-Interface selbst erscheinen, nicht versteckt in den AGB.

Der EU AI Act ersetzt nicht die DSGVO – beide Regelwerke gelten parallel. Ob du einen Datenschutzbeauftragten brauchst, hängt von deiner Unternehmensgröße und der Art der verarbeiteten Daten ab, nicht primär vom Chatbot selbst. Wenn dein Chatbot personenbezogene Daten verarbeitet (z.B. für personalisierte Empfehlungen), muss dies DSGVO-konform geschehen – unabhängig vom AI Act Status.

Fazit: Zukunft von KI Chatbots unter dem EU AI Act

Der EU AI Act markiert einen Wendepunkt für die Entwicklung und den Einsatz von KI Chatbots in Europa. Er schafft einen klaren regulatorischen Rahmen, der Innovationen fördert und gleichzeitig den Schutz der Grundrechte gewährleistet. Für Unternehmen bedeutet dies, dass sie bei der Entwicklung und dem Einsatz von KI Chatbots verstärkt auf Compliance und ethische Aspekte achten müssen.

Für E-Commerce-Unternehmen mit KI-Produktberatern geht es jedoch um mehr als nur Compliance: Es geht um Vertrauen. Ein transparenter, zuverlässiger Produktberater, der auf verifizierten Daten basiert und bei Unsicherheit an Menschen eskaliert, ist nicht nur rechtskonform – er ist auch effektiver. Kunden kaufen bei Unternehmen, denen sie vertrauen.

Die Zukunft von KI Chatbots unter dem EU AI Act verspricht eine Balance zwischen technologischem Fortschritt und verantwortungsvollem Einsatz. Unternehmen, die proaktiv die Anforderungen des Gesetzes erfüllen, werden nicht nur rechtliche Risiken minimieren, sondern auch das Vertrauen ihrer Kunden stärken. Letztendlich wird der EU AI Act dazu beitragen, dass KI Chatbots zu verlässlichen, transparenten und ethisch einwandfreien Werkzeugen in der digitalen Kommunikation werden.

Die Zeit zum Handeln ist jetzt. Die Fristen stehen fest, die Anforderungen sind klar. Nutze die verbleibende Zeit, um deinen Produktberater zukunftssicher aufzustellen – nicht als lästige Pflichtübung, sondern als strategische Investition in Kundenvertrauen und Conversion.

Unsere Lösung erfüllt alle EU AI Act Anforderungen: transparente Kennzeichnung, RAG-basierte Antworten ohne Halluzinationen und intelligente Eskalation an dein Team.

Kostenlose Beratung starten